上架模型版本¶

完成模型注册后,可上架模型的第一个版本。你可以将在智能实验室或在本机上开发的模型构建成可用于托管的模型镜像文件。

你也可以在系统提供的样例模型下,上架符合模型要求的版本。

上架版本¶

通过以下步骤,上架自建模型的第一个版本:

打开模型列表页,在自建模型列表中搜索并选择已注册的模型,选择进入模型详情页面。

在 版本管理 标签下,选择 版本上架,然后按照指引依次完成版本配置、构建日志、参数设置以及测试上架版本。

配置版本信息¶

在版本配置页面的 版本信息 一栏中,完成版本的基本信息配置:

版本规则:选择版本的命名规则,目前支持按上架版本时的系统时间戳命名版本

别名:输入模型版本的别名

架构基础:选择运行模型版本的基础硬件

协处理器:选择运行模型版本的协处理器,各类协处理器支持的计算框架如下:

GPU:支持 tensorflow、pytorch、spark、others(注:由于当前 IaaS 不支持 GPU,模型版本上架暂不支持 GPU 的能力)

TPU:支持 tensorflow、pytorch

VPU:支持 tensorflow、pytorch

无:默认选项,计算架构保持当前逻辑

计算框架:选择运行模型版本的计算框架

语言环境:选择开发模型版本的语言(与选择的计算框架相匹配)

发布者:输入发布模型版本的用户名称,默认为当前 EnOS 用户名称

描述:输入对模型版本的简要描述

在版本配置页面的 模型构建 一栏中,选择构建模型的方式,并完成对应的模型文件上传配置。对不同的输入数据类型(文本或图像),构建模型的方式也会不同。

选择 MLflow 或 Seldon 导入方式的可在 高级配置 中选择模型版本的保存地址和保存方式。

使用 OU 内置镜像仓库:镜像上传至 OU 内置的镜像仓库。

使用模型文件方式保存:采用模型文件打包方式,模型文件可以在智能套件中直接被调用。

文本输入数据类型¶

对文本类(Text 或 Tabular)输入数据类型,可通过以下方式完成模型构建:

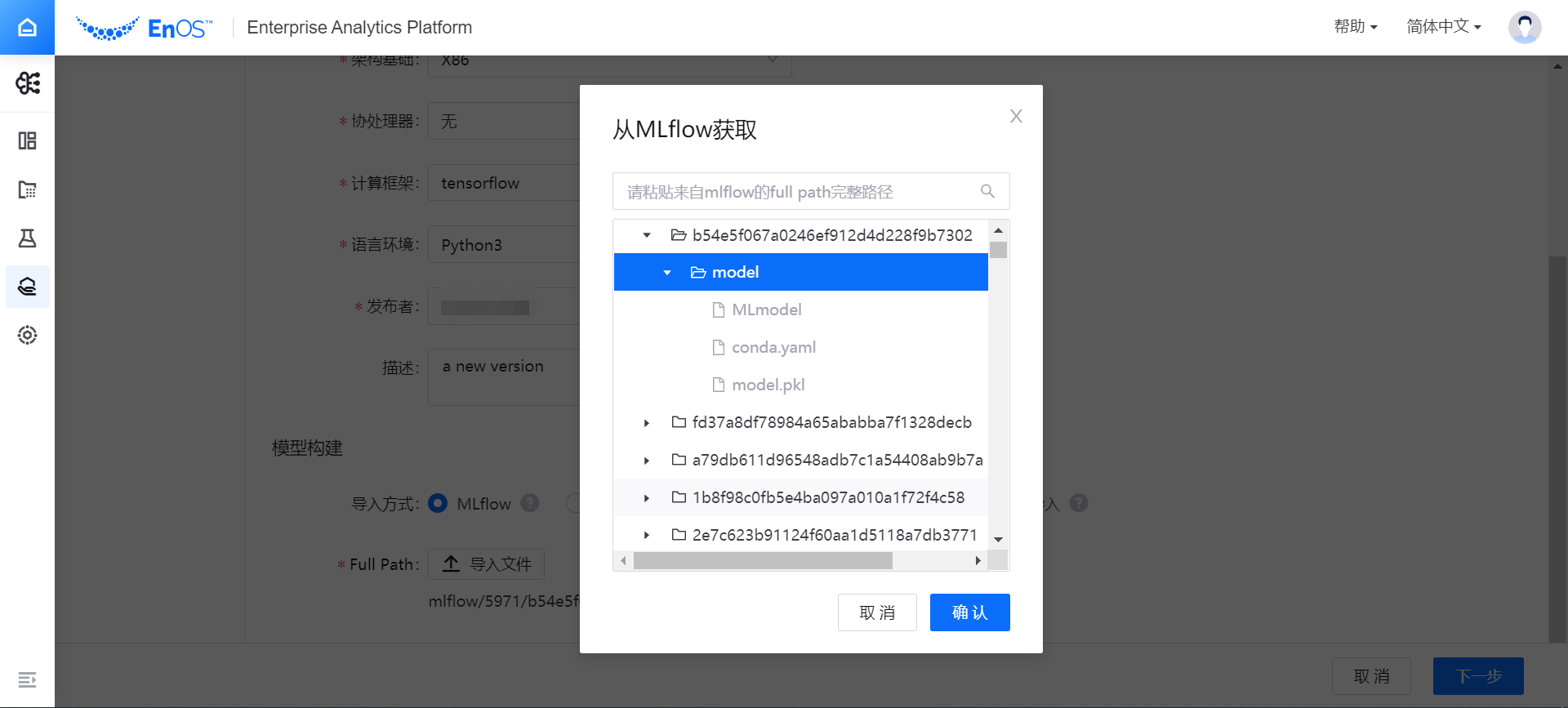

如选择 MLflow 导入方式,通过以下步骤选择构建模型版本的文件:

在 Full Path 一栏中,选择 导入文件。弹窗中将显示通过智能实验室训练任务生成的 Artifacts 文件。有关通过 MLflow 查看模型构建文件的详细信息,参考 查看实例运行结果。

浏览并选择需要构建的模型文件所在的目录后(目录层级为:项目名 > Run Name > 实例名),选择 确认。

选中的模型构建文件目录将显示在 Full Path 一栏中。

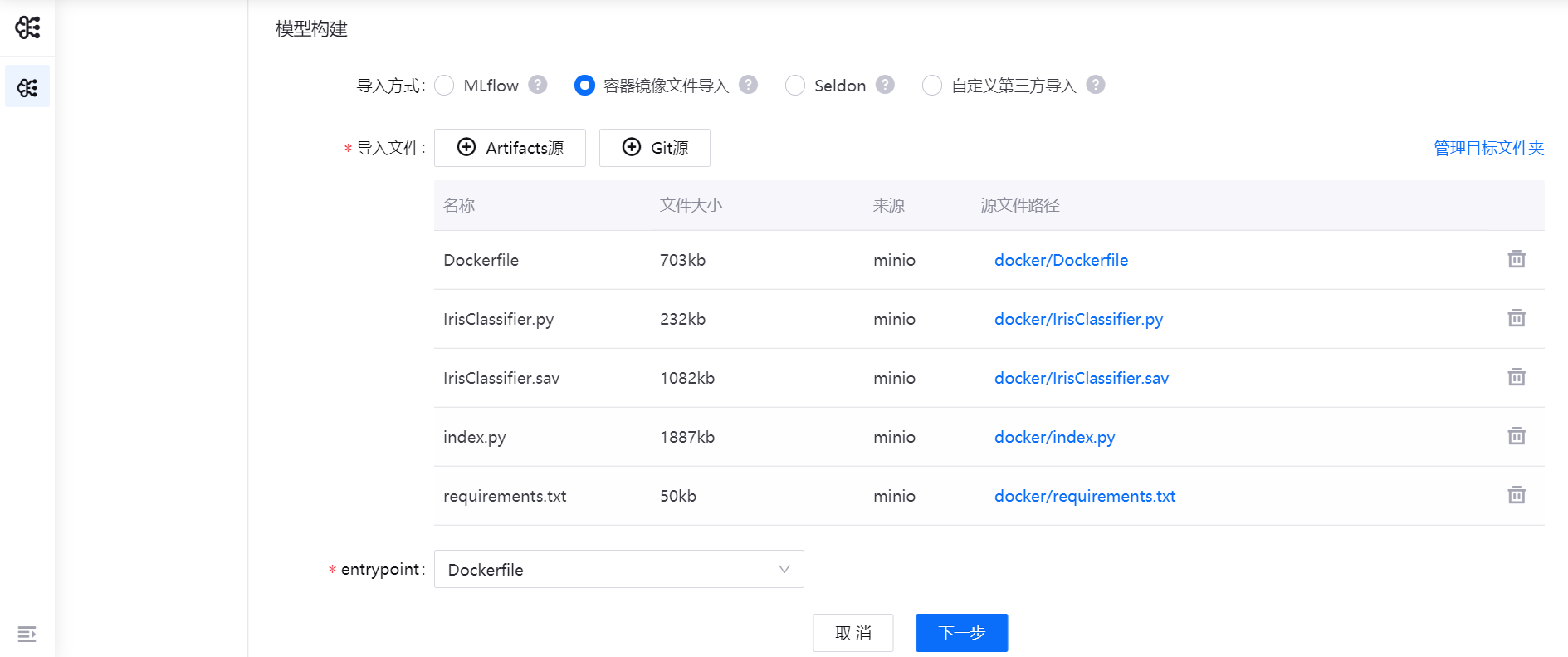

如选择 容器镜像文件导入,系统将自动指定文件夹所在位置,你可以从Artifacts源和Git源的多个层级目录中选择构建模型需要的目标文件。部署模型时,系统将使用指定的镜像部署成服务。

选择 Artifacts源 或 Git源,选择部署模型的镜像文件(可在两个源上反复多次操作选择文件;Git 源支持从分支或标签获取文件)。

在已选择的文件列表中,查看文件详细信息,移除不需要的文件。

在 Entry Point 下拉菜单中,选择

Dockerfile。

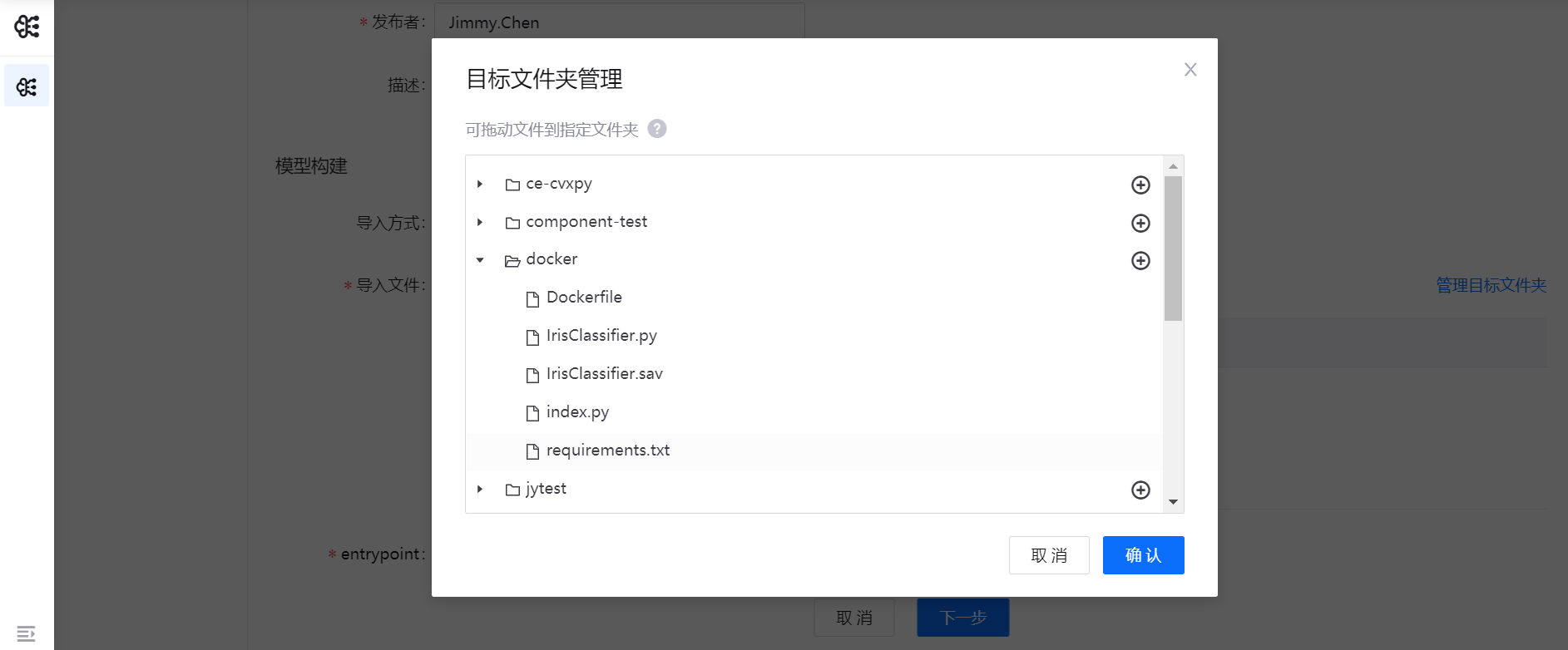

(可选)在从Artifacts源导入镜像文件时,如需管理目标文件夹中的目标文件,可选择页面右侧的 管理目标文件夹,在弹窗中拖动目标文件到指定文件夹,也可对目标文件夹进行管理操作。

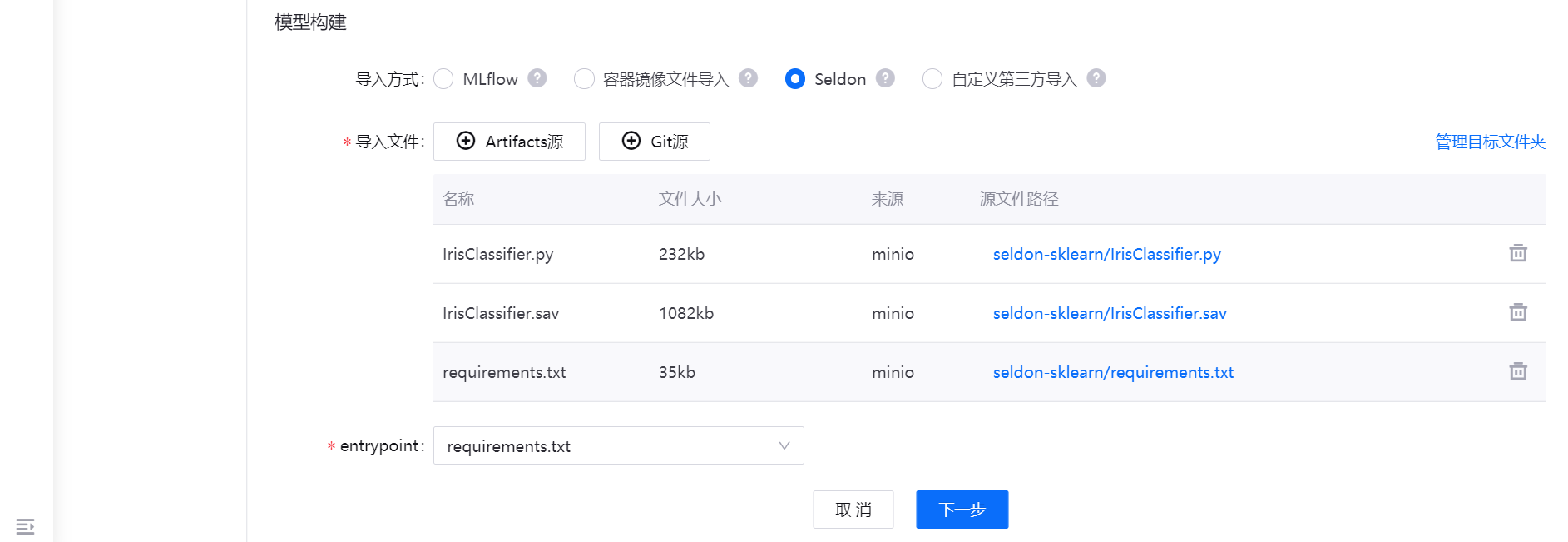

如选择 Seldon 导入方式,可使用s2i build从源代码创建Docker镜像。系统将自动指定文件夹所在位置,你可以从Artifacts源和Git源的多个层级目录中选择构建模型需要的目标文件。部署模型时,系统将使用指定的镜像部署成服务。

选择 Artifacts源 或 Git源,选择部署模型的镜像文件(可在两个源上反复多次操作选择文件;Git 源支持从分支或标签获取文件)

在已选择的文件列表中,查看文件详细信息,移除不需要的文件

在 Entry Point 下拉菜单中,选择入口文件。

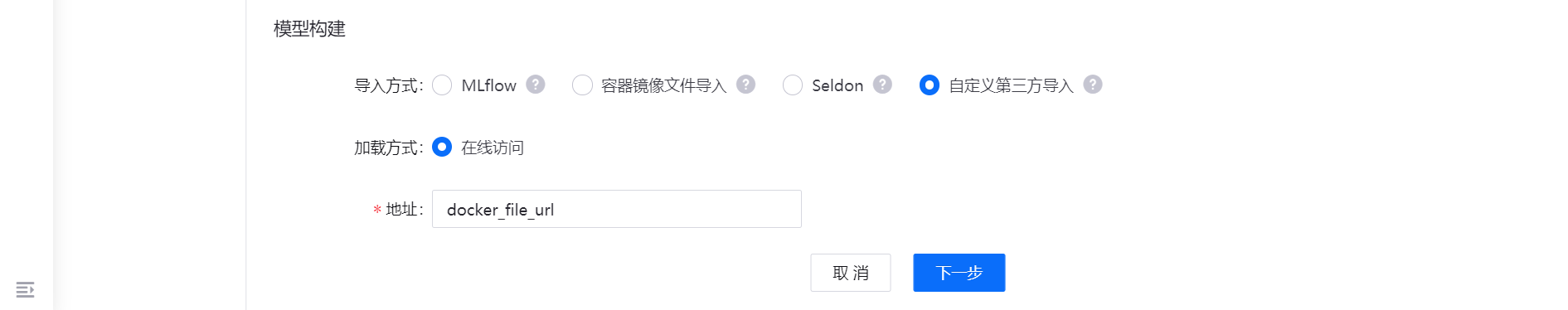

如选择 自定义第三方导入,可在第三方自定义的系统上将模型打包成为 Docker 镜像文件,然后导入。

目前支持在线访问的文件加载方式,在 地址 输入框中,输入获取模型文件的地址。

图像输入数据类型¶

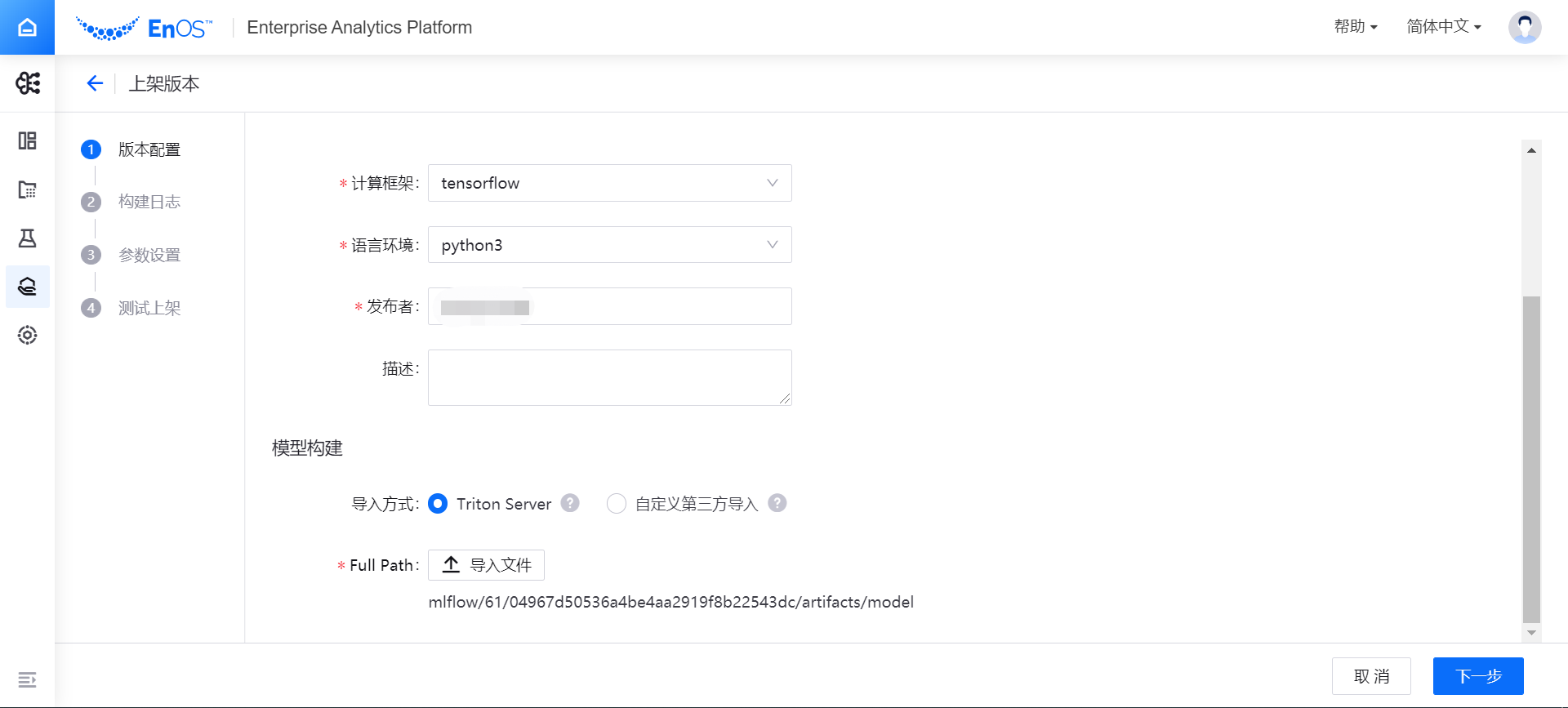

对图像(Image)输入数据类型,可通过以下方式完成模型构建:

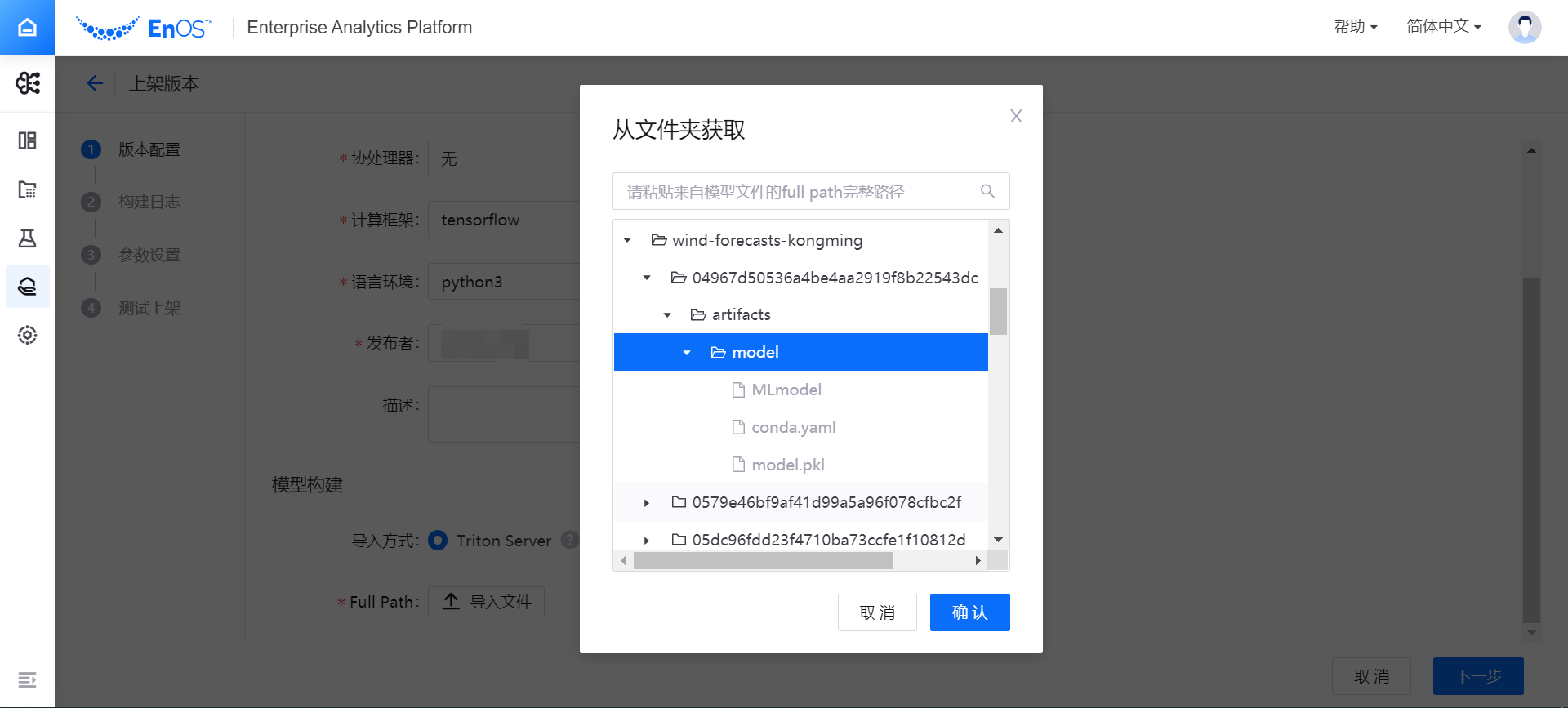

如选择 Triton Server 导入方式,通过以下步骤选择构建模型版本的文件:

在 Full Path 一栏中,选择 导入文件。弹窗中将显示通过智能实验室训练任务生成的 Artifacts 文件。有关通过 MLflow 查看模型构建文件的详细信息,参考 查看实例运行结果。

浏览并选择需要构建的模型文件所在的目录后(目录层级为:项目名 > Run Name > 实例名),选择 确认。

选中的模型构建文件目录将显示在 Full Path 一栏中。

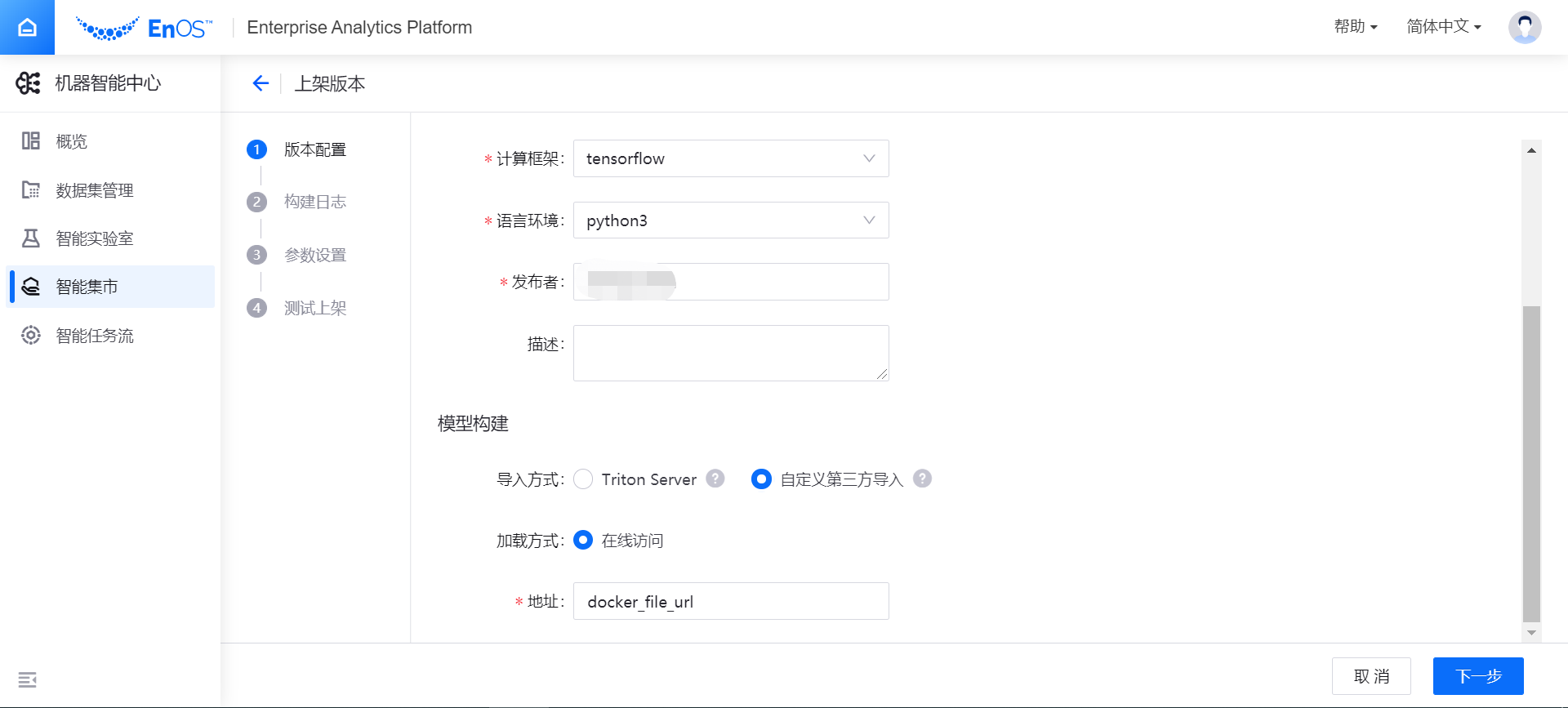

如选择 自定义第三方导入,可在第三方自定义的系统上将模型打包成为 Docker 镜像文件,然后导入。

目前支持在线访问的文件加载方式,在 地址 输入框中,输入获取模型文件的地址。

完成模型文件上传配置后,选择 下一步,系统将自动开始模型构建。

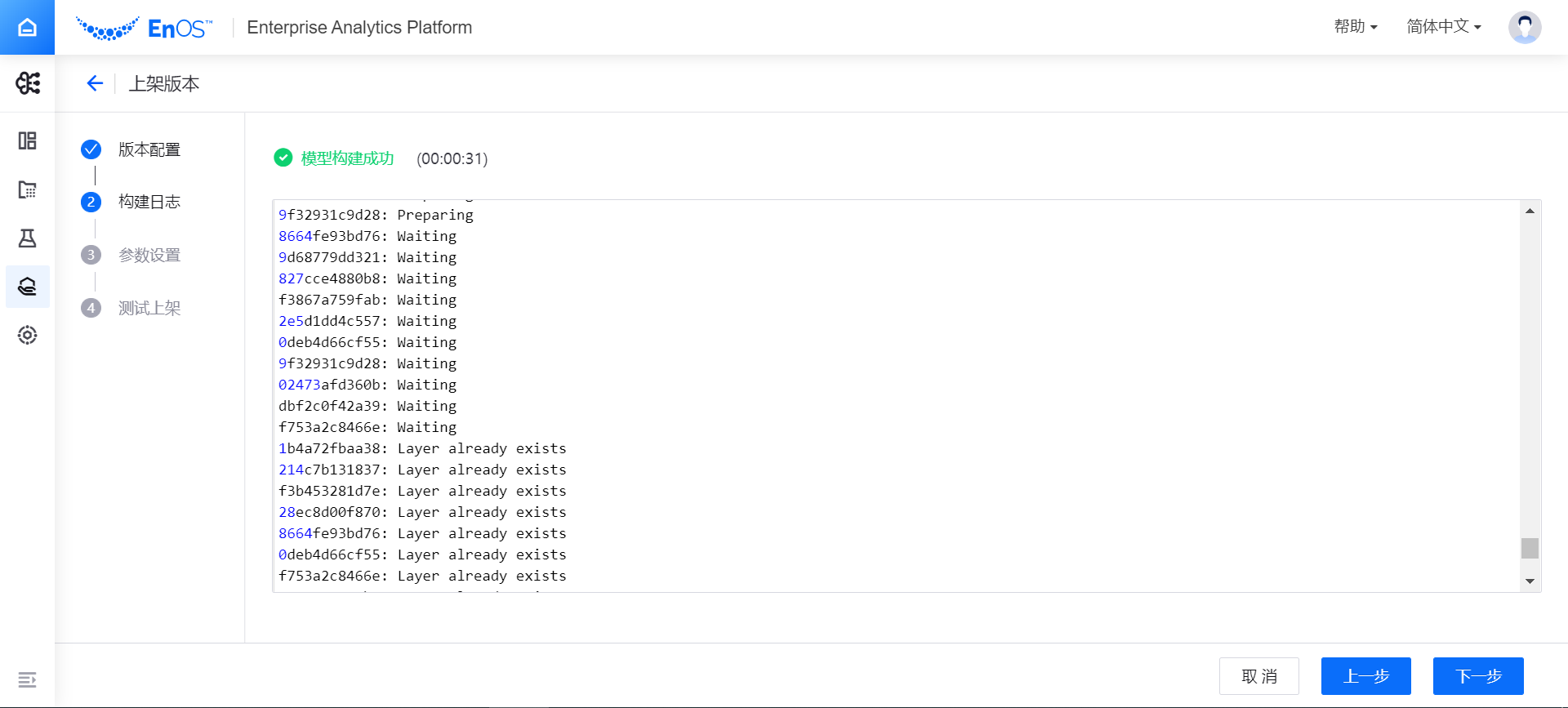

构建模型¶

在 构建日志 页面,查看模型的构建过程。构建日志将实时显示模型的构建过程,并记录构建耗费的时间。

若模型构建失败,可通过查看日志,定位失败的原因后,选择 上一步 修改配置。

模型构建成功后,可选择 下一步 完成参数设置。

设置模型参数(可选)¶

通过参数设置,可配置模型的定制参数,为非必填项,模型版本可以不设置参数。

测试上架模型¶

根据新建模型时设置的数据输入输出参数,写入测试脚本或上传测试图片,可测试模型版本是否能正常工作。对不同的输入数据类型(文本或图像),构建模型的方式也会不同。

文本输入数据类型¶

对文本类(Text 或 Tabular)输入数据类型,通过以下步骤完成模型测试:

在 参数输入 框中写入测试脚本,配置测试超时时间,选择 发起测试。注意:自动生成的特征参数的测试 JSON 文件大小不能超过32KB。

在 返回结果 框中查看模型版本的测试结果。

测试通过后,选择 完成,将模型版本发布上架(如无需测试模型版本,或测试失败,也可选择跳过测试,将模型版本强制上架)。

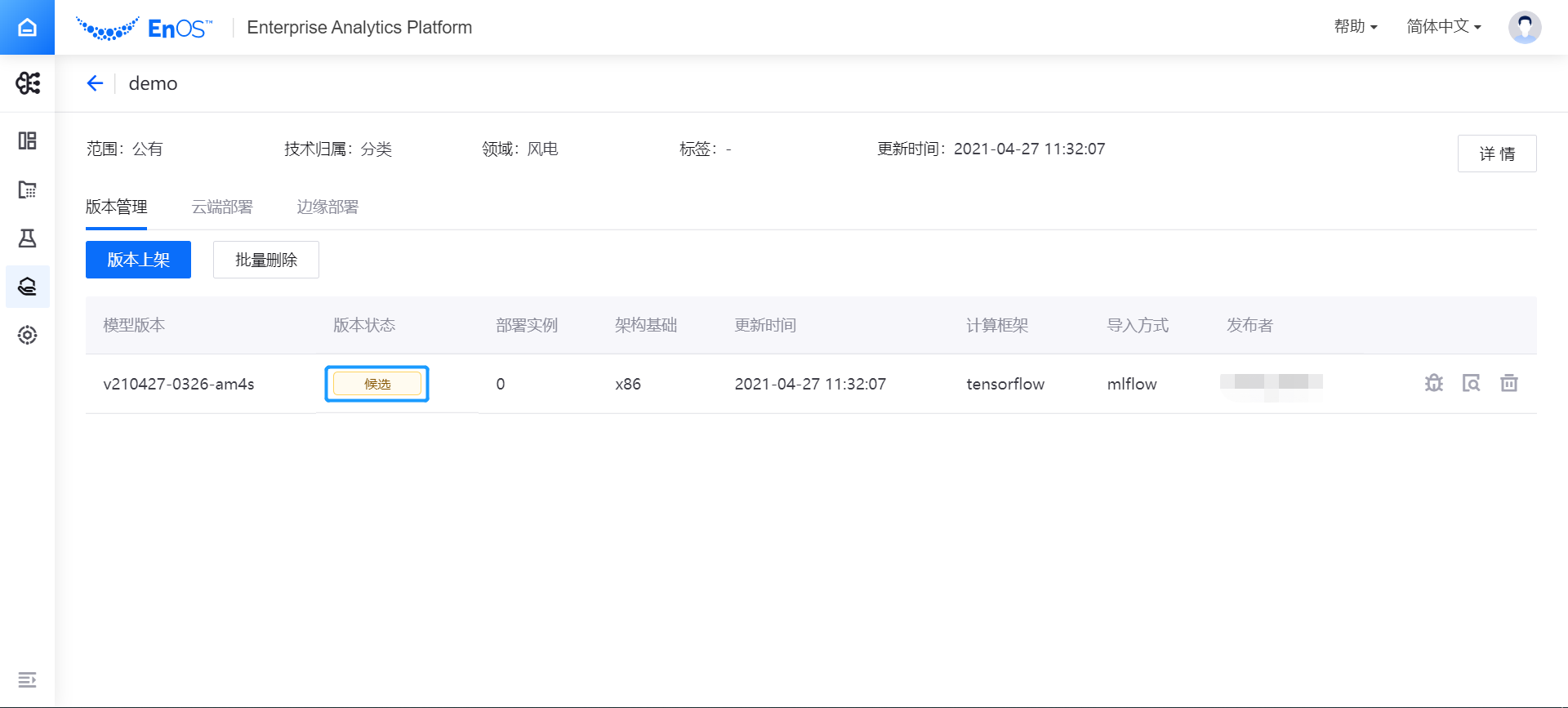

在模型详情页的 版本管理 标签下,查看已上架的模型版本。此时模型版本的状态为 候选,完成检查后,可将模型版本部署上线运行。

图像输入数据类型¶

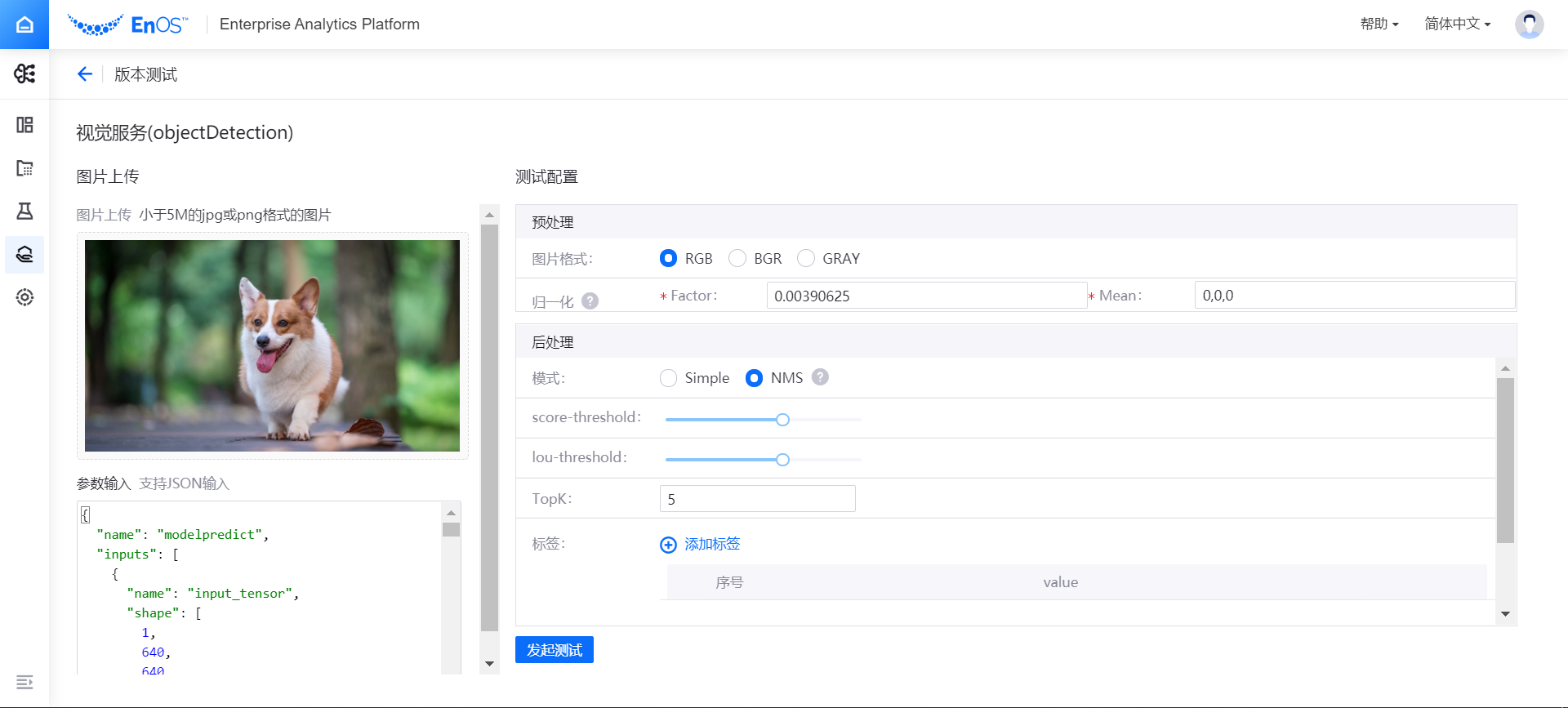

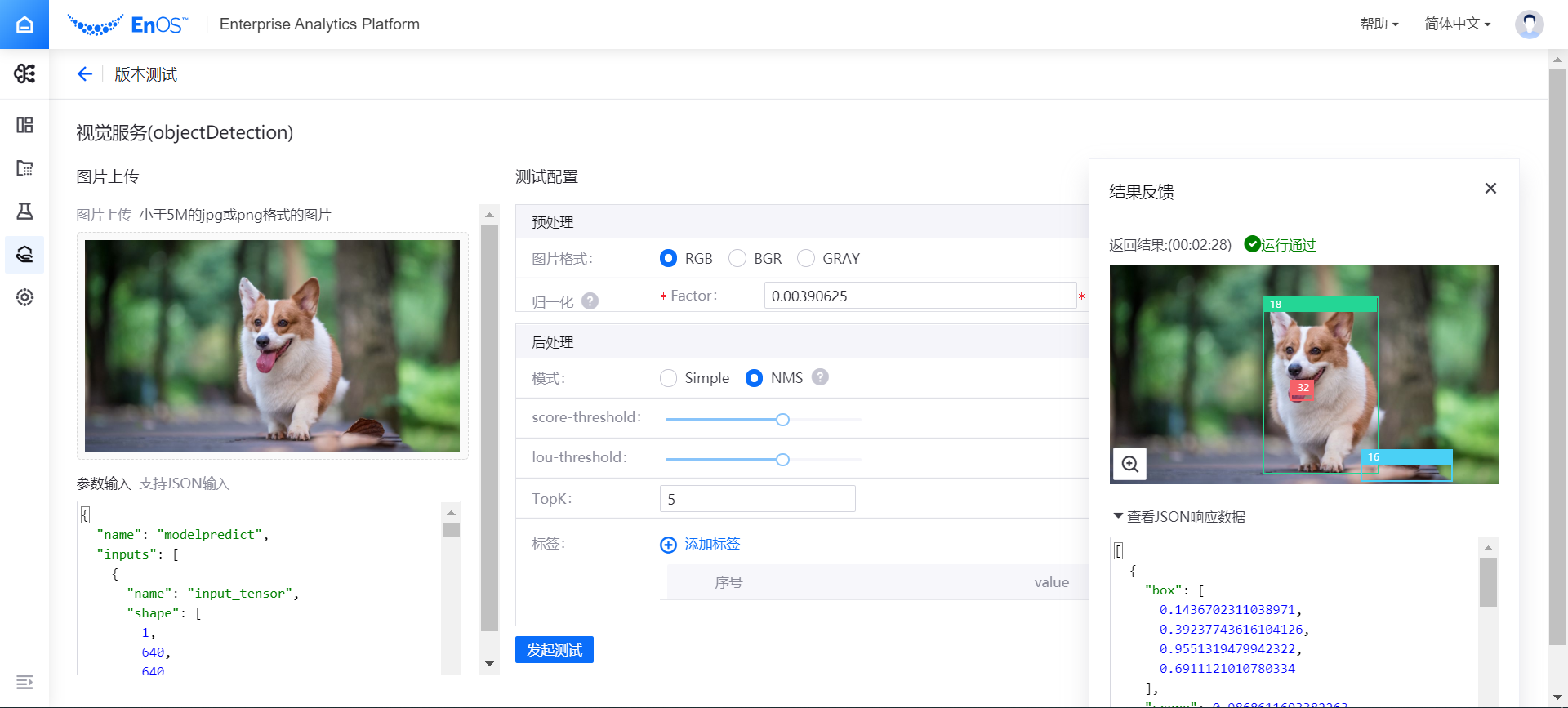

对图像(Image)输入数据类型,通过以下步骤完成模型测试:

在 图片上传 框中,选择并上传用于测试的图片(jpg或png格式),图片大小不能超过5MB。

在 参数输入 框中会自动生成模型版本测试的 JSON 文件,可根据需要进行修改。

在 测试配置 栏中,根据需要对图像进行预处理和后处理配置。

选择 发起测试,系统将根据测试配置信息开始运行模型版本测试。在 结果反馈 栏中,查看测试返回结果和 JSON 响应数据。

测试通过后,选择 完成,将模型版本发布上架(如无需测试模型版本,或测试失败,也可选择跳过测试,将模型版本强制上架)。

导出模型版本镜像¶

模型版本上架完成后,管理员或项目人员可导出模型版本镜像,用于在未安装智能实验室的私有环境中部署模型服务。

备注

由于模型版本的镜像文件通常较大,模型版本管理页面不再直接提供镜像下载功能。可在智能实验室 Notebook 实例中通过 Docker 命令下载模型版本镜像。详细步骤,参见 下载模型版本镜像>>。

基于现有模型版本快速上架¶

如需在原有模型版本基础上上架一个新版本,可在 版本管理 页面原有模型版本行选择复制版本 ![]() ,原模型版本的配置会自动导入,你可以按需修改并完成版本上架流程。

,原模型版本的配置会自动导入,你可以按需修改并完成版本上架流程。

下一步¶

完成模型版本上架后,可将版本部署上线,进入生产状态。详细信息,参考 部署上线模型版本。